Tal vez muchos no se han dado cuenta, pero los censores del siglo XXI ya no son personas, sino algoritmos.

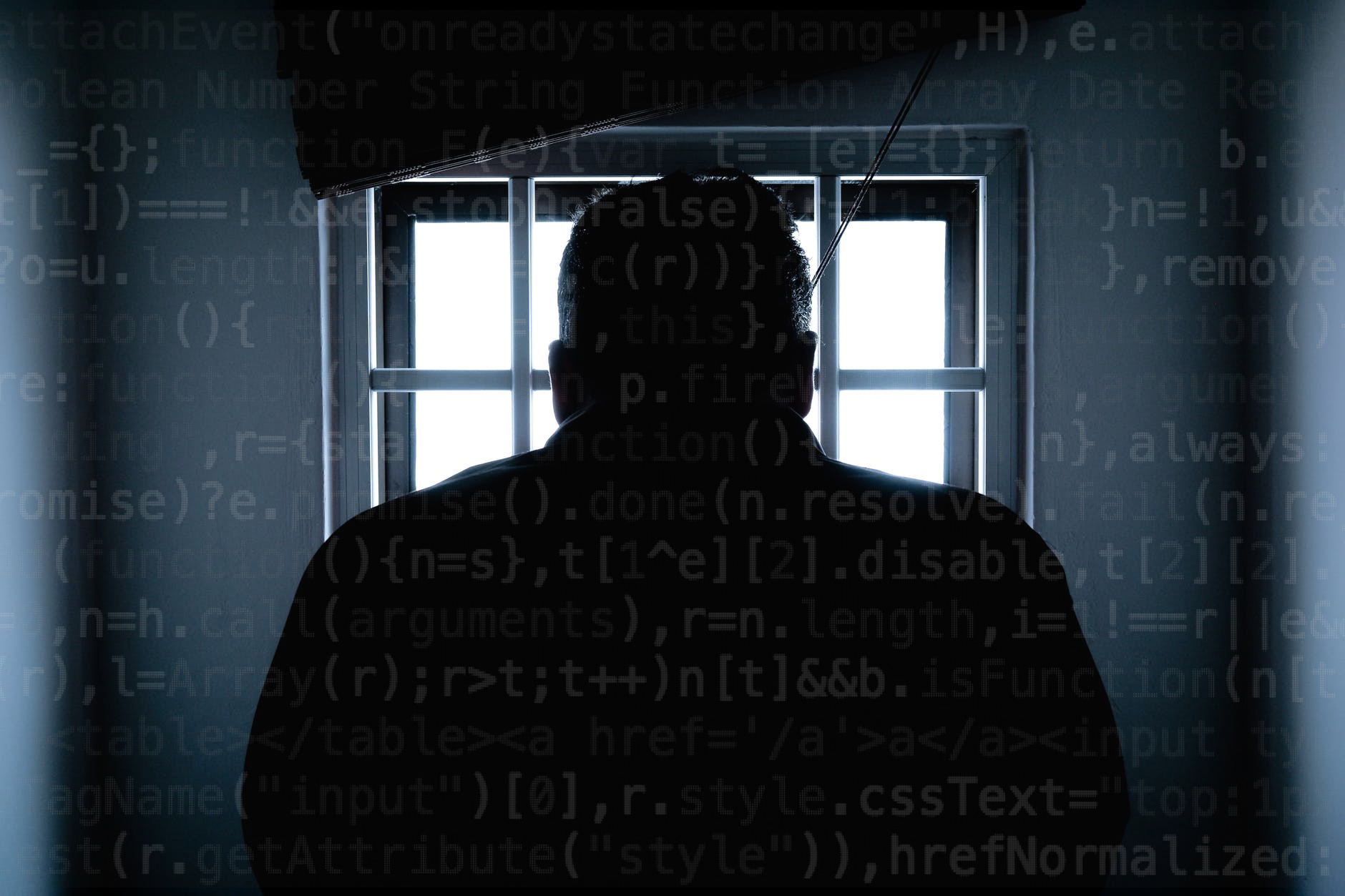

Es la inteligencia artificial quien puede tomar la última decisión a la hora de juzgar a un usuario quien, aparentemente, ha contravenido las normas dentro del ciberespacio.

Basta ver a Youtube (sobre todo estas últimas semanas con los últimos cambios en sus políticas). Los creadores de contenidos buscan sortear al algoritmo censor para evitar ser monetizados. Hoy hablan de la influencia del «nopor» en la sexualidad, o de la cultura del «n@rk0». Saben que están lidiando con un robot que analiza los contenidos arrojados en esa red social, y por tanto buscan la forma de engañarlo.

Un ser humano sabe a lo que esos contenidos se refieren, y sabe que quienes lo consumen también lo saben. Pero el algoritmo no (al menos por el momento), porque no tiene consciencia propia y tan solo es producto de ciertos inputs que lo definen y lo restringen (por más que tenga la capacidad de «aprender» por medio del machine learning). Peor aún, el algoritmo adopta los sesgos de su creador. Si el creador tiene prejuicios sobre algún tema o algún colectivo de personas, posiblemente, en alguna medida, el algoritmo terminará adoptándolos.

Pero así como al algoritmo se le puede engañar entendiendo su propia lógica, también dentro de ella es infalible y rígido. Si el algoritmo se «equivoca» es básicamente porque su construcción (por un agente externo como el ser humano) es perfectible, pero no se equivoca en sí mismo, es el agente externo el responsable de sus falencias. El algoritmo sigue a cabalidad las indicaciones que lo forman, por más sofisticadas que sean, y nunca se sale de ellas.

Por ello, el algoritmo no es alguien a quien se pueda persuadir ni se le puede apelar a sus emociones. El algoritmo es implacable: si concluye que tal contenido contraviene las normas, entonces aplica la sanción correspondiente sin piedad alguna. Así, Youtubers son sancionados por publicar ciertos contenidos con base en un frío y mecánico análisis que no saldrá nunca de los límites del algoritmo mismo. El algoritmo es capaz de detectar groserías en el audio e incluso es capaz de analizar imágenes y determinar si hay alguna esvástica o algo que aparente ser un desnudo.

Los Youtubers no tienen más de otra que apelar la decisión de tal forma que sean seres humanos los que lo revisen. Pero si los algoritmos están ahí es para agilizar actividades que con los seres humanos serían mucho más lentas. Entonces posiblemente pasen varios días para que aquel otro ser humano llegue a la conclusión de que fue una imperfección del algoritmo el que sancionó injustamente al Youtuber y retire la sanción. Sin embargo, el daño ya estará hecho.

En Facebook esto también ha sido un problema donde la presencia de los algoritmos censores, más que sortear los sesgos e intereses propios de los seres humanos, los exponencian.

Esto ocurre porque es un ser humano quien decide mandar a juicio a otro (donde los algoritmos son los jueces). Resulta que, en aras de crear un «mejor espacio de convivencia», los usuarios mismos reportan los contenidos que les parecen molestos. Un algoritmo analiza el contenido y emite un veredicto. ¿Cuál es el problema?

Que es muy común que muchos usuarios reporten aquellos contenidos que les parezcan incómodos, no porque sean agresivos o atenten contra alguien, sino simplemente porque no están de acuerdo con ellos o simplemente porque desean silenciar a quien piensa diferente. El algoritmo, por su parte, es incapaz de determinar la intención con la que la denuncia se hizo, éste solo verifica el contenido, la razón por la cual el demandante hizo la denuncia y que especifica en su plataforma (que si es discriminación o contenido violento) y entonces decide si sancionar o no al usuario en cuestión.

La denuncia toma fuerza si son varios los denunciantes ya que el algoritmo asume que si son varios quienes denunciaron el contenido, es porque este molesta a mucha gente. Pero es posible, y ocurre muchas veces, que los denunciantes se han puesto de acuerdo para buscar silenciar a tal o cual persona.

Por ejemplo, basta con subir una esvástica con fines ilustrativos para que otros usuarios lo denuncien y el algoritmo decida sancionar al usuario por hacer «apología al nazismo» cuando esa nunca fue su intención.

En Facebook también puedes apelar el frío y mecánico veredicto del algoritmo. Pero, igual, como los humanos son más lentos, más ineficientes y cuantitativamente limitados (es más fácil tener a millones de algoritmos que contratar a 100 personas para llevar a cabo un trabajo), entonces pasarán varios días para que al usuario, que era inocente, se le perdone.

Con el tiempo, los algoritmos se harán más sofisticados. Seguramente tendrán una mayor capacidad de entender las intenciones de los seres humanos que están detrás de las pantallas. Pero posiblemente nunca dejen de ser implacables en sus decisiones. El ser humano no tendrá a quien pedir piedad, el algoritmo simplemente tomará la decisión y no habrá nada que hacer al respecto.

Deja una respuesta